リモートワークで活躍するデータエンジニアの5つの条件とは?スキル・技術面についても考察

リモートワークで働くデータエンジニアは、もはや特別な選択肢ではなく、キャリアを考える上で有力な選択肢の一つとして定着しつつあります。

この記事では、データエンジニアの市場価値、リモートワークで得られるメリット、活躍するために必要なスキル)、企業が優秀な人材を見つける方法、そして個人で案件を獲得するまでの流れを、分かりやすく解説します。

リモートワークのデータエンジニアが求められる理由と市場価値

ここでは、データエンジニアの仕事内容とその将来性や市場価値について、詳しく解説していきます。

データエンジニアの主な仕事内容

| フェーズ | 主な仕事内容 | 目的・役割 |

| 設計 | データ基盤のアーキテクチャ設計、技術選定(クラウドサービス等) | ビジネスの目的に合った、効率的で安全なデータ活用の青写真を描く。 |

| 開発 | データパイプラインの構築(データの抽出・変換・格納処理の実装) | 様々な場所からデータを集め、使える形に整えて目的地まで届ける仕組みを作る。 |

| 構築・運用 | DWH/データレイクの構築、パフォーマンス監視、障害対応 | データの保管庫を作り、安定的に稼働させ続けることで、いつでもデータを取り出せる状態を保つ。 |

| 品質管理 | データ品質の担保、データカタログの整備、セキュリティ管理 | データの正確性や信頼性を守り、誰もが安心してデータを使える環境を維持する。 |

データエンジニアは、組織のデータを収集・処理・保存・提供するためのデータ基盤やシステムを設計・構築・運用する技術者です。

主な仕事内容

- データパイプラインの構築

- データウェアハウス・データレイクの設計

- データ品質の管理

- リアルタイムデータ処理

- パフォーマンス最適化

- セキュリティとコンプライアンス

データパイプラインの構築

様々なデータソース(データベース、API、ログファイル、外部サービスなど)からデータを収集し、変換・加工して目的の形式に整えるETL/ELTパイプラインを設計・実装します。これにより、データサイエンティストやアナリストが分析に使えるデータを提供します。

データウェアハウス・データレイクの設計

大量のデータを効率的に保存・管理するためのストレージシステムを設計します。Amazon Redshift、Google BigQuery、Snowflakeなどのクラウドサービスや、Hadoop、Sparkなどの分散処理基盤を活用することが多いです。

データ品質の管理

データの欠損や重複、不整合を検出・修正する仕組みを構築し、データの信頼性を保ちます。データバリデーション、監視アラート、自動修正機能などを実装します。

リアルタイムデータ処理

Apache Kafka、Apache Storm、Amazon Kinesisなどを使って、リアルタイムでデータを処理・配信するシステムを構築します。最近はApache FlinkやApache Beamが多く使われることもあります。

パフォーマンス最適化

クエリの実行速度向上、システムの負荷分散、コスト削減などの観点からシステムを継続的に改善します。

セキュリティとコンプライアンス

個人情報保護やデータガバナンスの要件を満たすよう、アクセス制御や暗号化、監査ログの仕組みを実装します。GDPRやCCPAなどの法令対応も含まれることがあります。

データエンジニアは、データ活用の土台となるインフラを支える重要な役割を担っており、現代のデータドリブンな組織には欠かせない職種です。

データエンジニアに向いている人とは

どんな人がデータエンジニアに向いているか特徴を見ていきましょう。以下のような特徴を持つ人に向いているとされています。

技術的な適性

論理的思考力が高く、複雑なシステムを設計・構築することを楽しめる人が向いています。プログラミングが好きで、SQL、Python、Java、Scalaなどの言語に興味を持って学習できる継続力も重要です。

使われる主な技術・ツール例

| 分野 | よく使われる技術・サービス |

|---|---|

| プログラミング言語 | Python、SQL、Java |

| クラウドDWH | BigQuery、Redshift、Snowflake |

| データ処理 | Apache Spark、Airflow、dbt |

| リアルタイム処理 | Kafka、Flink、Kinesis |

| インフラ構成 | Terraform、Docker、Kubernetes |

また、クラウドサービスやデータベース技術の変化が激しいため、新しい技術を積極的に習得する意欲が必要です。

問題解決への姿勢

データの品質問題やパフォーマンス課題など、目に見えない問題を粘り強く調査・解決できる人が向いています。エラーログを読み解いたり、データの流れを追跡したりする作業に集中できる忍耐力も求められます。

コミュニケーション能力

データサイエンティストやアナリスト、ビジネス部門など様々な職種の人と連携する機会が多いため、技術的な内容を分かりやすく説明できる能力が重要です。

また、要件を正確に理解し、適切なデータ基盤を設計するためのヒアリング力も必要です。

細かい作業への適性

データの整合性チェックやETL処理の設計など、細かい作業に集中できる人が向いています。

一見地味に見える作業でも、組織のデータ活用の基盤を支えているという使命感を持てることが大切です。

スケーラビリティへの意識

将来のデータ量増加やユーザー増加を見越して、拡張可能なシステムを設計できる先見性があると良いでしょう。短期的な解決だけでなく、長期的な視点でアーキテクチャを考えられる人が重宝されます。

なぜデータエンジニアはリモートワークと相性が良いのか

データエンジニアの業務は、そのほとんどがパソコンとインターネット環境さえあれば完結します。

- クラウド上でのサーバー構築や設定

- プログラミング言語を用いたデータ処理システムの開発

- チームメンバーとのオンラインでの打ち合わせ

このように、物理的に出社しなくても十分に高いパフォーマンスを発揮できる素地があります。そして、この働き方が生産性向上に直結することは、客観的なデータも示しています。

日本生産性本部が2024年に発表した「第15回 働く人の意識調査」によると、在宅勤務を行う人のうち実に78.9%もの人が「オフィス出社時と比べて効率が上がった」と回答しています。

特に、データエンジニアの業務は、この恩恵を最も受けやすい典型例と言えます。データパイプラインの複雑なロジックを組み立てたり、ETLジョブ(様々なデータを抽出し、使える形に変換して格納する一連の処理)の稼働状況を監視したりといった業務は、静かな環境でこそ高い集中力を発揮できます。

通勤ストレスから解放され、自身の生産性を最大化できる静かな環境で働けることは、データエンジニアにとって大きなメリットです。

最新データで見るリモートワークデータエンジニアの将来性

データエンジニアの需要は、今後も伸び続けると予測されています。事実、ITエンジニアの市場は非常に活発で、専門性の高いスキルを持つ人材の価値は高まる一方です。

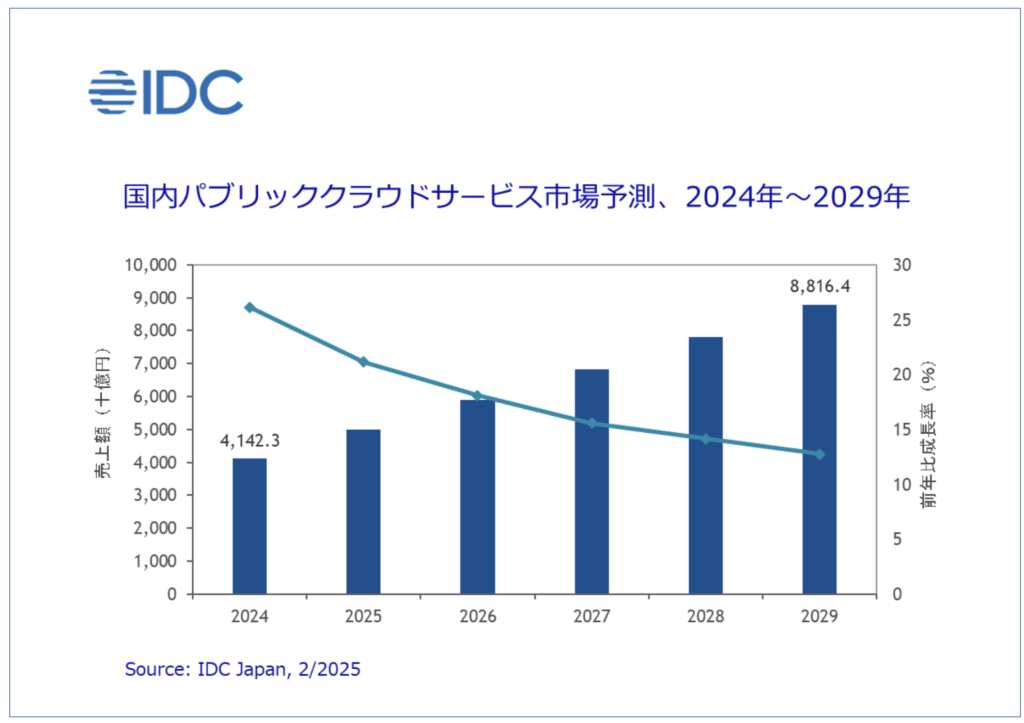

その需要を裏付けるのが、データエンジニアの主戦場であるクラウド市場の成長です。調査会社のIDC Japanが発表した予測によると、日本のパブリッククラウド市場は2029年の市場規模は2024年比約2.1倍の8兆8,164億円に達すると予測しています。

出典:IDC Japan株式会社「国内パブリッククラウドサービス市場予測を発表」

なぜ、クラウド市場の成長がデータエンジニアの将来性に直結するのでしょうか。

それは、現代のデータレイクやデータストリーミング基盤といったシステムが、クラウド上で構築・運用されるのが当たり前(クラウドネイティブ)になっているためです。インフラの管理や開発が、もはや物理的な場所を問わないエンジニアリング体制が常態化しています。

つまり、クラウド市場の拡大は、そのままリモートで活躍できるデータエンジニアの求人増に繋がるという、非常に分かりやすい構図なのです。この巨大な成長市場で専門スキルを持つ人材の価値は、今後も高まり続けるでしょう。

リモートワークのデータエンジニアとして働く5つのメリット

リモートワークでデータエンジニアとして働くことには、たくさんの魅力があります。ここでは、特に大きなメリットを以下の内容で紹介します。

- 通勤時間ゼロで得られる生産性とQOLの向上

- 場所の制約から解放され自由なライフスタイルを実現

- 集中できる環境で複雑なデータ課題に没頭

- 全国の高単価案件に挑戦して収入アップを目指せる

- 自己投資の時間を確保し市場価値を高め続けられる

【メリット1】通勤時間ゼロで得られる生産性とQOLの向上

毎日の通勤にかけていた時間、無駄だと感じたことはありませんか。

例えば1日に往復2時間を通勤に使っていた場合、1年間で約480時間もの時間が生まれます。その時間を、新しい技術を学ぶ自己投資の時間にしたり、家族と食卓を囲む時間にしたり、趣味に没頭する時間にしたりと、自由に使えるのは大きな魅力です。

そして、通勤がなくなるメリットは、単に時間が生まれるだけではありません。精神的な負担の軽減という、非常に大きな効果もあります。

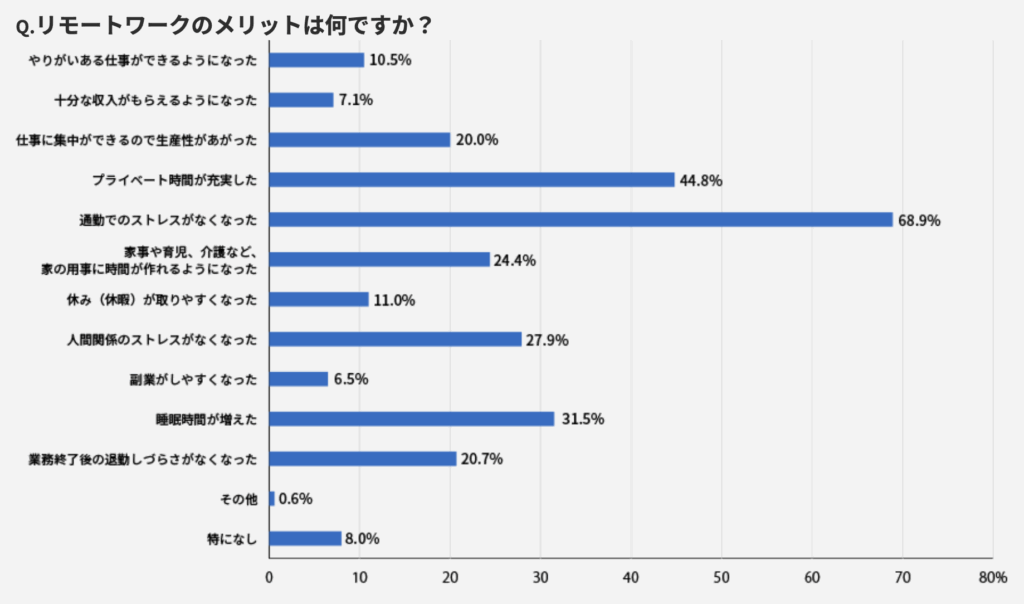

テレリモ総研の調査では、リモートワークによって「通勤ストレスがなくなった」と答えた人は68.9%にものぼります。

出典:【2024年度版】テレワークのメリット・デメリットとは? | テレリモ総研

多くの人が、満員電車や交通渋滞といった移動そのものから来るストレスから解放されているのです。

こうして生まれた時間的・精神的な余裕は、日中の業務における集中力の持続や、不要な残業の削減に直結します。

常に新しい技術を学び続ける必要があるデータエンジニアにとって、ストレスなく、集中できる時間を自らの意思でコントロールできることは、スキルアップと生活の質(QOL)を両立させる上で、計り知れない価値を持ちます。

【メリット2】場所の制約から解放され自由なライフスタイルを実現

リモートワークは、なんといっても働く場所を自分で決められることです。

田舎に戻って家族と過ごしながら最新のプロジェクトに参加したり、自然豊かな場所でのびのびと子育てをしながらキャリアを継続したり。そんな理想のライフスタイルを実現できる可能性が広がります。

地方に暮らしながら、都市部の企業が発注する先進的な業務委託案件に携わる。場所という制約がなくなるだけで、人生の選択肢は大きく増えるのです。例えば、数ヶ月単位で滞在先を変えながら仕事をするワーケーションを実践したり、海外から日本のプロジェクトに参加したりすることも可能です。

クラウド上で業務が完結するデータエンジニアだからこそ、その自由度は格別と言えます。これは、都心に集中しがちな仕事を地方へ分散させ、地域経済の活性化にも貢献できる新しい働き方です。

【メリット3】集中できる環境で複雑なデータ課題に没頭

データエンジニアの業務には、データパイプラインのアーキテクチャ設計や、パフォーマンスが求められるSQLクエリの作成など、深い思考と集中力が必要な場面が多くあります。

オフィスでの突発的な声かけや周囲の雑音に気を取られることなく、自宅の書斎や好きなカフェなど、自分が最も集中できる環境で仕事に取り組めます。質の高い静かな環境が、質の高いアウトプットを生み出すのです。

オフィスでは、会議の合間や短い時間で複雑な処理を考えなければならないことも。しかしリモートワークなら、誰にも邪魔されずに数時間じっくりと腰を据えて、最適なアーキテクチャを練り上げられます。

思考が中断されないため、凡ミスが減り、手戻りの少ない高品質な仕事に繋がるのです。これはクライアントからの信頼にも直結する、大きなメリットと言えるでしょう。

【メリット4】全国の高単価案件に挑戦して収入アップを目指せる

仕事を受ける上で、収入は非常に重要な要素です。リモートワークであれば、住んでいる地域に関係なく、日本全国、時には海外の高単価な仕事や業務委託案件に挑戦できます。特にデータ基盤の構築や刷新といった大規模なプロジェクトは、発注元が都市部の企業であることが多い傾向にあります。

この「都市部の高単価案件」と「地方の低い生活コスト」の組み合わせが、実際に大きな経済的メリットを生みます。

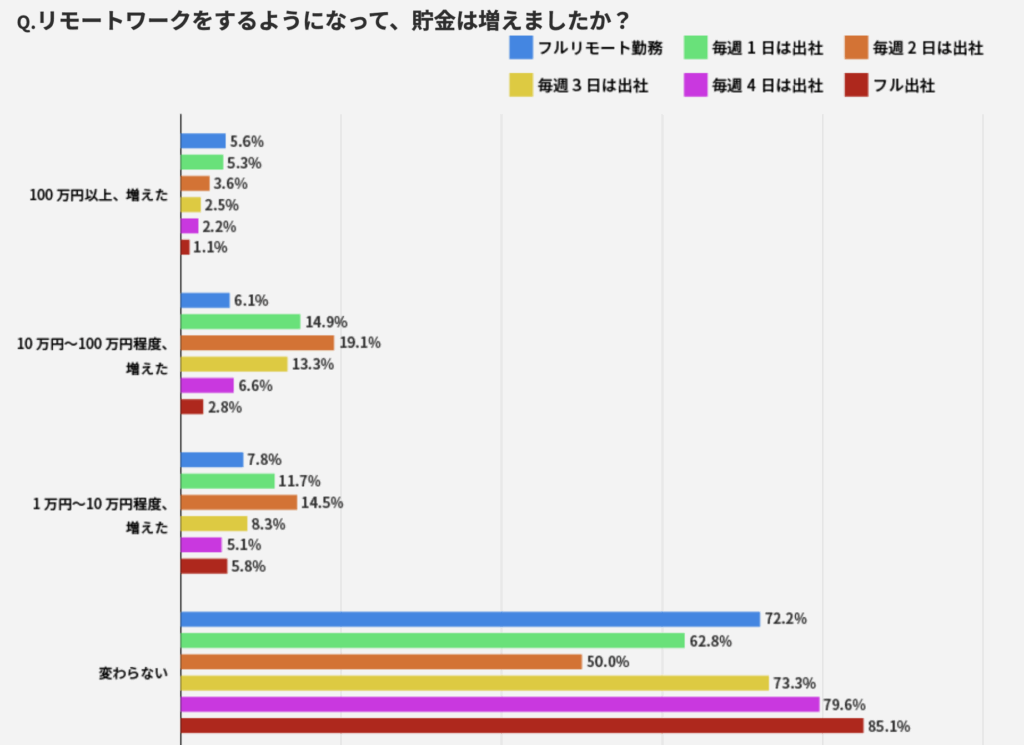

テレリモ総研の調査によると、完全フルリモート勤務は、フル出社の人に比べて「貯金額が100万円以上増えた」と回答した割合が約2倍にものぼります。

出典:リモートワークと貯金の関係を大調査!100万円以上増えた強者も!? | テレリモ総研

さらに、通勤がなくなったことで生まれる時間を副業にあて、追加の収入を得ることも可能です。スキルさえあれば、住む場所の制約なく収入を最大化し、同時に生活コストを最適化できる。これは、リモートで働くデータエンジニアならではの特権と言えるでしょう。

【メリット5】自己投資の時間を確保し市場価値を高め続けられる

データエンジニアは、技術の進化が非常に速いのが特徴です。新しいクラウドサービスやデータ処理技術が次々と登場するため、常に学び続ける姿勢が欠かせません。

リモートワークで生まれた時間を、AWSやGCPといったクラウドの認定資格の勉強にあてたり、海外の技術イベントにオンラインで参加したりと、自身のスキルアップに有効活用できます。

継続的な自己投資が市場価値をさらに高め、次の高単価案件に繋がる好循環を生み出します。

リモートワークで活躍するデータエンジニアにおすすめのスキル

リモートワークで働くデータエンジニアとして成功するためには、技術力だけでなく、働き方に対応したスキルも必要です。ここでは、企業から選ばれ、高い評価を得続けるために不可欠なスキルを紹介します。

技術スキル – クラウドとデータベースの知識

| スキル領域 | 初心者に求められるレベル |

|---|---|

| SQL(データベース操作) | SELECT文、JOIN、GROUP BYなどの基本操作 |

| クラウド知識 | クラウドサービスの概要を理解し、GUIベースで操作できる |

| データ処理フロー | ETLの概念を理解し、ツールを使った実装経験があると◎ |

| プログラミング | Pythonが少しでも書けると強みになる |

| チーム開発経験 | Gitの基本操作、コードレビューへの対応力など |

今日のデータ基盤の多くはクラウド上に構築されており、AWS、GCP、Azureといった主要クラウドの基本的な理解は重要です。特に実務経験があると転職に有利ですが、必要な知識は入社後にキャッチアップすることも可能です。

単にサービスを使えるだけでなく、コストを最適化し、セキュリティを担保した上で、最適なインフラを設計・構築できる能力が求められます。

では、数ある技術の中で、特にどれを優先して学ぶべきなのでしょうか。

「Stack Overflow Developer Survey 2024」の調査によると、開発者が最も使用するデータベースとして「PostgreSQL」が49%の支持を得て2年連続の首位となりました。また、コンテナ技術である「Docker」は、最も使われる開発ツールとして59%の圧倒的な使用率を誇っています。

これらの技術を本番環境で問題なく運用できるスキルは、即戦力が求められる業務委託のリモート案件の面接時のチェック項目になると考えた方がよいでしょう。

もちろん、これら以外にも、以下のような多岐にわたる知識を組み合わせて活用する能力が重要です。

| 分類 | 主要な技術・サービス例 | なぜ重要か |

| クラウド | AWS, Google Cloud (GCP), Microsoft Azure | 現代のデータ基盤の土台。各サービスの特徴を理解し、要件に合わせて選定・設計する。 |

| DWH | Google BigQuery, Snowflake, Amazon Redshift | 大規模なデータを分析用に保管・集計するための高速なデータベース。 |

| ストレージ | Amazon S3, Google Cloud Storage | あらゆる形式のデータを大量かつ安価に保管する場所(データレイク)として利用される。 |

| データベース | SQL (PostgreSQL等), NoSQL (MongoDB等) | 構造化データや非構造化データなど、データの特性に応じた最適なデータベースを選択・操作する。 |

データパイプライン構築スキル – Pythonと分散処理

データをA地点からB地点へ、必要な形に加工しながら安定的に運び続ける仕組み、データパイプラインを構築するスキルは、データエンジニアの中核をなす能力です。

プログラミング言語のPythonや、Airflow、Apache Sparkといったワークフロー管理・分散処理のフレームワークを使いこなせることは、大量のデータを扱う案件で信頼を勝ち取るための強力な武器になります。

データパイプライン構築で求められる代表的なスキルセットは、以下の通りです。

| 分類 | 主要な技術・サービス例 | なぜ重要か |

| プログラミング言語 | Python | データ処理用の豊富なライブラリ(Pandas等)があり、事実上の標準言語となっている。 |

| ワークフロー管理 | Apache Airflow, Dagster, Prefect | 複雑なデータ処理の順序や依存関係を定義し、自動で実行・監視する。 |

| 分散処理 | Apache Spark | 1台のマシンでは処理しきれない巨大なデータセットを、複数のマシンで連携して高速に処理する。 |

| ストリーム処理 | Apache Kafka, Apache Flink | リアルタイムで発生し続けるデータ(例:アプリの操作ログ)を、即座に処理する。 |

リモートワークを円滑にするコミュニケーションスキル

顔が見えないリモートワーク環境では、コミュニケーションの質が仕事の成果を大きく左右します。チャットツールなどテキストでのやり取りが中心になるため、要点を的確に、かつ誤解なく伝える能力が極めて重要です。

また、受け身ではなく、自ら進んで業務の進捗を報告したり、課題を共有したりする能動的な姿勢が、クライアント企業からの信頼に直結します。技術力が高くても、コミュニケーションが円滑でなければ、継続的な仕事には繋がりにくいでしょう。

具体的には、以下のポイントを意識すると、リモートでのコミュニケーションは格段にスムーズになります。

テキストの精度を上げる

結論から先に書く「PREP法」を意識したり、背景や目的をセットで伝えたりすることで、相手の理解を助け、手戻りを防ぎます。文章だけでは冷たい印象になりがちなため、適度に絵文字を使うなどの配慮も有効です。

仕事の「見える化」を徹底する

「今、何に取り組んでいるのか」「どこで困っているのか」を、聞かれる前に自分から発信することが信頼に繋がります。特に、少しでも問題が発生しそうな予感がしたら、すぐに共有することが、後々の大きなトラブルを防ぐ上で非常に大切です。

非同期と同期を使い分ける

急ぎではない情報共有や相談はチャット(非同期)で行い、相手の時間を尊重します。一方で、複雑な仕様の確認や意見が分かれそうな議題は、Web会議(同期)を設定して対話で解決するなど、状況に応じた最適な手段を選ぶ判断力が求められます。

自律的に動くための自己管理能力

フリーランスとしてリモートワークで働くことは、大きな自由が手に入る反面、すべてを自分で管理しなくてはならないことを意味します。

- タスクの優先順位付けと進捗管理

- 自分自身で定めた就業時間や休憩のルールを守る

- モチベーションを維持するための工夫

誰かに指示されなくても、責任感を持って自律的に仕事を進める自己管理能力は、リモートで働く上での大前提となります。

信頼を勝ち取るセキュリティスキル

データエンジニアは、企業のビジネス戦略に関わる重要なデータや、時には個人情報といった機密性の高い情報を取り扱う仕事です。そのため、人一倍高いセキュリティ意識を持つ必要があります。

総務省が公開している「テレワークセキュリティガイドライン」などを参考に、VPNの利用、データの暗号化、アクセス権の管理といった基本的な対策を徹底しましょう。

たった一度のセキュリティ事故が、キャリアを致命的なものにしかねません。

【企業の採用担当者向け】 リモートワークで優秀なデータエンジニアを採用する秘訣

ここからは、視点を変えて企業の人事・採用担当者に向けて、リモートワークで優秀なデータエンジニアを見つけ、共に成功するための方法を解説します。

優秀な人材は、もはやオフィスの近くにいるとは限りません。

採用で見極めるべきポイントはスキルと自律性

業務委託でデータエンジニアを探す際、技術力の見極めは当然重要です。GitHubで公開されているコードや過去のポートフォリオは、その人のスキルレベルを判断する貴重な材料になります。

同時に、それと同じくらい重要なのが、候補者がリモート環境で自律的に業務を遂行できるかを見極めることです。単にスキルがあるだけでなく、主体的に仕事を進められる人材かどうかが、プロジェクトの成否を分けます。

以下の表では、具体的なチェックポイントと、それを見極めるための質問例をまとめました。

| 評価ポイント | 確認する内容 | 確認方法の例 |

| 技術スキル | データ基盤の設計・構築能力、プログラミングの質 | ポートフォリオで過去のプロジェクト構成図や成果物を確認する。面談で「なぜその技術を選んだのか」を質問する。 |

| 自己管理能力 | タスクやスケジュールの管理方法、モチベーションの維持方法 | 「普段、どのようにタスクを管理していますか?」といった質問で、具体的な手法や工夫を聞き出す。 |

| コミュニケーション | テキストでの伝達能力、報告・連絡・相談のスタイル | 「過去のリモート案件で、コミュニケーションやタスク管理で工夫した点は何ですか?」といった質問をする。 |

| 問題解決能力 | 未知の課題に対する調査・解決プロセス | 「一人で解決が難しい技術的課題に直面した時、どう行動しますか?」と質問し、思考プロセスを見る。 |

成功を左右するリモートでのオンボーディング

優秀な人材を見つけても、チームへの受け入れ体制が整っていなければ、その能力を十分に発揮させることはできません。特にリモートワークでは、最初のオンボーディング(受け入れプロセス)が極めて重要です。

- 相談役となるメンターを明確に決める

- 開発環境や社内ルールに関するドキュメントを整備しておく

- チーム内のコミュニケーションルール(定例会議、チャットの使い方など)を最初に共有する

最初の1ヶ月でいかにスムーズにチームに馴染んでもらえるかが、プロジェクトの成否を分けます。

パフォーマンスを引き出す評価とマネジメント

リモートで個人をマネジメントする上で大切なのは、時間で管理するのではなく、成果で評価することです。日々の細かな行動を監視するマイクロマネジメントは、エンジニアのモチベーションを下げ、生産性を落とす原因になりかねません。

最高のパフォーマンスを引き出すには、相手を信頼し、支援するスタンスで関わることが不可欠です。具体的には、以下のような仕組みを取り入れるのが有効です。

- 明確なゴールの共有

- 定期的な1on1ミーティング

- オープンなコミュニケーションの場

- 成果物での正当な評価

まず、プロジェクト開始時に期待する成果物や達成目標(ゴール)を明確に共有し、評価の基準をすり合わせます。

その上で、週に一度などの定期的な1on1を通じて進捗の確認や課題のヒアリングを行い、信頼関係を築くことが大切です。日々の業務が円滑に進むよう、朝会やチャットなどで気軽に意見交換できるオープンな場も用意しましょう。

そして何より、稼働時間ではなくアウトプットの質と量で正当に評価する文化を築くことが、エンジニアの自律性と生産性を最大限に引き出します。

データエンジニア向けのリモート案件獲得法から業務の進め方

ここでは、データエンジニアとしてリモートワーク案件を獲得し、仕事を成功させるまでの具体的な流れを見ていきましょう。準備をしっかり整えれば、道は必ず拓けます。

高単価なリモートワーク案件の見つけ方

高単価で良質なリモートワーク案件は、残念ながら待っているだけではなかなか見つかりません。積極的に情報を集めに行く姿勢が大切です。

その最も有効な方法の一つが、リモート案件に特化した専門のエージェントに登録することです。エージェントは、一般には公開されていない優良な非公開案件を多数保有しています。

例えば、Remogu(リモグ)は登録・利用が完全に無料で、ご紹介する案件はすべてリモートワーク案件です。月収80万円を超える高単価な仕事が豊富なだけでなく、副業としても最適な週2日から働ける案件や、夜間対応の案件など、ライフスタイルに合わせた柔軟な働き方を提案できます。

Remoguの強みは約80%が非公開案件であることです。そして専任のエージェントが営業活動から面倒な条件交渉までをすべて代行します。 手厚いフォローによって高い継続率を実現しており、開発業務に集中し、安定したキャリアを築けるよう支援します。

差がつくポートフォリオの作り方

ポートフォリオは自分自身のスキルを証明する最も重要な名刺です。単に作ったものを並べるだけでなく、どのようなビジネス課題に対し、どういった技術を選定し、どんな工夫をして解決したのか、というストーリーを語れるようにまとめましょう。

特にデータエンジニアのポートフォリオで、採用担当者から評価されやすい掲載例をいくつか紹介します。

- 課題解決ストーリーを語るプロジェクト概要

- システム構成図(アーキテクチャ図)

- パフォーマンス改善の証明(Before/After)

- 公開可能なサンプルコード(GitHub)

- 使用技術とその選定理由

例えば「手動で3日かかっていた売上集計を、10分で自動完了するデータ基盤を構築した」というように、ビジネス上の課題と、それをどう解決したのかを明確に記述します。その上で、作成したデータ基盤の構成図を載せると、あなたの設計能力が一目で伝わります。

もし既存システムの改修であれば、処理時間やコストといったパフォーマンス改善を具体的な数値(Before/After)で示すことは、貢献度を証明する上で絶大な効果があります。

また、公開できる範囲で、品質を意識して書かれたコードをGitHubに上げておくことも、実際のプログラミングスキルを示す強力な証拠となります。使用した技術を羅列するだけでなく「なぜそのクラウドサービスやデータベースを選んだのか」という選定理由まで語れると、より評価は高まるでしょう。

クライアントの期待を超える!業務の進め方と報告の技術

リモートワークで高い評価を受け、次の契約更新や単価アップに繋げるには、単に言われた通りの業務をこなすだけでは不十分です。

クライアントから「期待以上の価値を提供してくれる、ビジネスパートナーだ」と思ってもらうための、一歩進んだ仕事の進め方と報告の技術が求められます。

そのための具体的なテクニックは、以下の通りです。

- 期待値の事前すり合わせ

- 課題の早期発見と解決策の提案

- 定例報告でのプラスアルファ情報

- 成果の可視化とビジネス貢献への言及

まず、業務に着手する前に「何を作るか」だけでなく「なぜ作るのか」という背景や目的まで、クライアントと深くすり合わせましょう。

目的を理解することで、より本質的な提案が可能になります。業務の途中で課題や改善点を見つけたら、ただ報告するのではなく「こうしたリスクがあるので、このように改善しませんか?」と解決策をセットで提案する姿勢が、あなたの価値を大きく高めます。

定例報告では、単なる進捗の共有に留まらず、専門家としての気づきや考察を「プラスアルファ」として添えるのが効果的です。

そして、完了報告の際は、「言われたことをやる」だけでなく、常に一歩先を考え、ビジネスの成功に貢献する姿勢を示すことが、クライアントの信頼を勝ち取り、期待を超える評価に繋がるのです。

まとめ

データエンジニアという専門性と、リモートワークという自由な働き方の掛け合わせは、エンジニアにとっても、人材を求める企業にとっても、非常に大きな可能性を秘めています。

リモートワークで活躍したい方は、本記事で紹介したスキルを意識して磨き、自身の価値を証明できるポートフォリオを準備しましょう。

そして企業担当者の皆様は、採用やマネジメントのやり方をリモートワークに最適化することで、これまで出会えなかった全国の優秀な人材と共に、事業を成長させることができます。

フリーランスや副業のエンジニアと企業の業務委託案件を繋ぐリモートワーク専門のエージェントです。

場所という制約から解放され、データと共に新しいキャリアを築き始めましょう。